Developing, Purchasing, Implementing and Monitoring AI Tools in Radiology:

Developing, Purchasing, Implementing and Monitoring AI Tools in Radiology:

Practical Considerations.

A Multi-Society Statement from the ACR, CAR, ESR, RANZCR and RSNA

Radiology: Artificial IntelligenceVol. 6, No. 1

2024.01.22.

DOI: 10.1148/ryai.230513

Developing, purchasing, implementing and monitoring AI tools in radiology:

Developing, purchasing, implementing and monitoring AI tools in radiology:

practical considerations.

A multi-society statement from the ACR, CAR, ESR, RANZCR & RSNA.

Insights Imaging 15, 16 (2024.01.22.).

https://doi.org/10.1186/s13244-023-01541-3

Kulcspontok:

■ A mesterséges intelligencia (AI) beépítése a radiológiai gyakorlatba megköveteli hasznosságának és biztonságának fokozott ellenőrzését

■ A fejlesztők, a klinikusok és a szabályozó hatóságok közötti együttműködés lehetővé teszi valamennyi érintett számára az etikai kérdések kezelését és az AI teljesítményének nyomon követését

■ A mesterséges intelligencia akkor válthatja be a betegek jólétének előmozdítására tett ígéretét, ha a fejlesztéstől az egészségügyi ellátásba való integrálásig minden lépést szigorúan értékelnek

1. szakasz: Bevezetés

A mesterséges intelligencia (AI) valószínűleg az elmúlt évtizedek, és talán szakterületünk kezdetei óta a radiológiát leginkább befolyásoló hatású dolog. A mesterséges intelligencia olyan változások lehetőségét kínálja, amelyek messze túlmutatnak a korábbiakon. A mesterséges intelligencia bajnokai néha azt sugallták, hogy a mesterséges intelligencia teljesen felválthatja a radiológusokat, bár néhányan később felülvizsgálták nézeteiket, és veszélyeket látnak a mesterséges intelligencia ellenőrizetlen fejlődésében. Reálisabb, hogy a mesterséges intelligenciát egyre inkább a képalkotásban a radiológus által irányított kiegészítőként kutatják. A kutatások arra is irányulnak, hogy a mesterséges intelligenciahogyan helyettesítse a radiológusok hagyományos szerepeit, beleértve a vizsgálatok és protokollok kiválasztását, valamint a radiológiai leletek mesterséges intelligencia modellek általi közvetlen generálását.

A radiológiában a mesterséges intelligenciát övező egyre növekvő szakirodalom, publicitás és állítások közepette hogyan tudja a radiológus, egy vezető vagy a szoftverek vásárlója elválasztani a búzát a pelyvától, kritikusan értékelni a mesterséges intelligencia hasznosságára és hasznára vonatkozó állításokat, megkülönböztetni a teljes mértékben értékelt és biztonságos termékkínálatot azoktól, amelyek a reklámozottól eltérő módon működhetnek, vagy ami még rosszabb, kárt okozhatnak?

Ebben a több társaságot érintő dokumentumban az ACR, a CAR, az ESR, az RANZCR és az RSNA képviselői megpróbálják meghatározni a mesterséges intelligencia radiológiai gyakorlatba való beépítésével kapcsolatos konkrét lehetséges problémákat, valamint a felmerülő etikai kérdéseket, azokat a szempontokat, amelyeket a mesterséges intelligencia eszközök fejlesztőinek szem előtt kell tartaniuk, azokat a kérdéseket, amelyeket a mesterséges intelligencia eszközök klinikai használatra történő engedélyezésére vagy tanúsítására jogosultaknak figyelembe kell venniük, azt, hogy a vásárlóknak és a felhasználóknak hogyan kell értékelniük a mesterséges intelligencia eszközöket, amikor fontolóra veszik a klinikai gyakorlatba való bevezetésüket, hogyan kell nyomon követni a hosszú távú stabilitásukat és biztonságukat, és hogyan kell értékelni az autonóm működésre való alkalmasságukat.

2. szakasz: Mi a probléma?

A. Miért különböznek a mesterséges intelligencia algoritmusai a radiológia korábbi informatikai/informatikai fejlesztéseitől?

A radiológiában mintegy 30 éve használt hagyományos, számítógéppel támogatott felismerő (CADe) vagy diagnosztikai (CADx) rendszerek szabályalapúak, klasszikus gépi tanulási technikákat használnak, kézzel készített jellemzőkkel. A rendszer által észlelni kívánt jellemzőket, például az elváltozás alakját, méretét vagy textúráját kézzel előre meghatározták, majd a radiológiai képeken lévő rendellenességek észlelésére használták. Bár hasznos volt, a CAD-nek korlátot szabott a manuális tervezés szükségessége, valamint az, hogy nem volt képes tanulni és idővel alkalmazkodni.

A modern AI-algoritmusok, különösen a mélytanuláson alapuló algoritmusok alapvetően különböznek a hagyományos CAD-től azáltal, hogy explicit meghatározás és programozás nélkül, automatikusan tanulják a releváns jellemzőket az adatokból. A mélytanuló algoritmusok nagy adathalmazokon való betanítással képesek megtanulni a radiológiai képek mintázatainak azonosítását, és elvileg folyamatosan tanulni és javítani a teljesítményüket, ahogy egyre több adatot kapnak. A mély tanulási modellek képzése történhet felügyelt tanulással (ma leginkább használt, bemeneti és kívánt kimeneti párokat bemutató), felügyelet nélküli tanulással (a rendszer osztályokba sorolja az adatokat) vagy megerősítő tanulással (a rendszer jutalmazás vagy büntetés révén tanul).

Egy másik fontos különbség az automatizálás szintje, amelyet a mesterséges intelligencia algoritmusok a radiológiában megvalósíthatnak. Míg a hagyományos CAD-rendszerek segíthetnek a rendellenességek felismerésében, az AI-algoritmusok számos rutinszerű radiológiai feladatot, például a képszegmentálást és -mérést, a képminőség értékelését automatizálhatják, és hatalmas mennyiségű adat valós idejű elemzésével döntéstámogatást nyújthatnak.

A mesterséges intelligencia radiológiai alkalmazása új kihívásokat jelent, mint például a mesterséges intelligencia algoritmusok képzéséhez szükséges nagy, annotált adathalmazok szükségessége, a mesterséges intelligenciával kapcsolatos döntések átláthatóságának és értelmezhetőségének biztosítása, valamint etikai és szabályozási megfontolások kezelése.

B. Miért kell új módon értékelnünk a mesterséges intelligencia modelleket, mielőtt azok rutinszerű klinikai használatba kerülnének?

A radiológiában a legtöbb mesterséges intelligencia modellt az elváltozások felismerésének vagy számszerűsítésének támogatására vagy a radiológusok döntéshozatalának segítésére használják. Egyes újabb megközelítések a betegek kórtörténetének elemzésében vagy a vizsgálati leletek és/vagy vélemények megírásában is segítenek. A mesterséges intelligencia modellek radiológiában történő biztonságos működésének biztosítása érdekében elengedhetetlen a radiológusok és más potenciális végfelhasználók oktatása a mesterséges intelligencia elveiről, valamint a mesterséges intelligenciamodellek használatának korlátairól és lehetséges kockázatairól.

Fontos továbbá, hogy a klinikai gyakorlatba való bevezetés előtt értékeljék a mesterséges intelligencia modellek pontosságát a célpopuláción, a bevezetés után pedig figyelemmel kell kísérni a modellek teljesítményét a pontosságban bekövetkező eltérések észlelése érdekében.

Az AI-algoritmusok integrálása a radiológiai munkafolyamatba kulcsfontosságú a biztonságos és következetes működésük biztosításához. A mesterséges intelligencia integrációjára vonatkozó, széles körben elfogadott szabványok hiánya még mindig kihívást jelent. Ebben az összefüggésben figyelmet kell fordítani az interfész kialakítására. Nem kívánatos, hogy a radiológusokat egyre több és bonyolultabb interfésznek tegyük ki, ami csökkentheti az AI-eszközök hasznosságát és elfogadottságát.

C. Hogyan tudunk különbséget tenni a kínálkozó termékek sokasága között?

A mesterséges intelligencia integrálása a radiológiába forradalmasíthatja az egészségügyi gyakorlatokat, mivel fejlett megoldásokat kínál számos állapot diagnosztizálására, számszerűsítésére és kezelésére. Az AI-modellek értékelése azonban túlmutat a klinikai pontosságon, és üzleti és technikai megfontolásokat is magában foglal. Ezeket, valamint annak egyéb szempontjait, hogy a potenciális felhasználók és vásárlók hogyan értékelhetik a mesterséges intelligencia eszközeit a bevezetés előtt, a 6. szakasz részletesen tárgyalja.

3. szakasz: Melyek az etikai kérdések?

Az orvosi etika négy alapelvre épül:

- jót tenni

- ne okozzunk kárt

- a beteg választási szabadsága

- méltányosság biztosítása.

Ezek az elvek a legtágabb értelemben vett orvosi gyakorlatra vonatkoznak, és ezért magukban foglalják a radiológiai mesterséges intelligenciával kapcsolatos etikai megfontolásokat. Ez a szakasz több érdekelt fél - többek között az AAPM, ACR, CAR, ESR, EuSoMII, RANZCR, RSNA és SIIM - munkájára támaszkodik, és a mesterséges intelligencia rendszerek fejlesztése, telepítése, használata és ellenőrzése során felmerülő etikai kérdéseket vizsgálja.

2019-ben a fenti társaságok többsége együttműködött a mesterséges intelligencia etikájáról a radiológiában szóló nyilatkozat megalkotásán, amely a következő főbb üzeneteket fogalmazta meg:

- Az AI-nak a radiológiában elő kell mozdítania a jólétet, minimalizálnia kell az ártalmakat, és biztosítania kell, hogy az előnyök és ártalmak igazságosan oszoljanak meg az érdekeltek között.

- A mesterséges intelligenciának tiszteletben kell tartania az emberi jogokat és szabadságokat, beleértve a méltóságot és a magánéletet. A lehető legnagyobb átláthatóság és megbízhatóság érdekében kell kialakítani.

- A mesterséges intelligenciáért a végső felelősség és elszámoltathatóság továbbra is az emberi tervezők és üzemeltetők kezében marad.

- A radiológiai közösségnek etikai és gyakorlati kódexeket kell kidolgoznia a mesterséges intelligenciára vonatkozóan, amelyek támogatnak minden olyan felhasználást, amely a betegeket és a közjót szolgálja, és megakadályozzák a radiológiai adatok és algoritmusok pénzügyi haszonszerzésre történő felhasználását e két tulajdonság nélkül.

- Kiterjedt kutatásra van szükség annak megértéséhez, hogy miként lehet a legjobban alkalmazni a mesterséges intelligenciát a klinikai gyakorlatban.

- A mesterséges intelligencia potenciális buktatókat és eredendő elfogultságokat hordoz magában. Az AI-alapú intelligens és autonóm rendszerek széles körű alkalmazása a radiológiában növelheti a nagy következményekkel járó rendszerszintű hibák kockázatát, és rávilágít az összetett etikai és társadalmi kérdésekre.

Kulcsfontosságú nyilatkozat

A mesterséges intelligenciának a radiológiában elő kell segítenie a jólétet, minimalizálnia kell a károkat, tiszteletben kell tartania az emberi jogokat, mint például a méltóság és a magánélet tiszteletben tartása, és biztosítania kell, hogy az előnyök és a károk igazságosan oszoljanak meg az érdekelt felek között.

Mivel a mesterséges intelligencia kritikus mértékben függ az adatoktól, az adatok megszerzésével, felhasználásával, tárolásával és megsemmisítésével kapcsolatos etikai kérdések központi szerepet játszanak a betegbiztonság és a mesterséges intelligencia megfelelő alkalmazása szempontjából. Fontos etikai kérdések kapcsolódnak a beleegyezéshez, a magánélethez és az adatvédelemhez, az adatok tulajdonjogához, az elfogultsághoz és a méltányossághoz, az átláthatósághoz és a mesterséges intelligenciának a klinikai gyakorlatba való integrálásához.

Adatvédelem, hozzájárulás és adattulajdonjog - A radiológiai AI-rendszereknek a képzéshez és a működéshez nagy mennyiségű betegadathoz kell hozzáférniük. Ezen adatok etikus felhasználásának biztosítása magában foglalja a betegek magánéletének megőrzését, az adatok felhasználásához szükséges tájékozott beleegyezés megszerzését és az adatbiztonság garantálását. A betegadatok tulajdonjogát több tényező is befolyásolja: a vonatkozó jogszabályok, a betegek magánélete és autonómiája, a szélesebb közérdek, az egészségügyi szolgáltatók és a mesterséges intelligencia fejlesztőinek érdekei, valamint szerzői jogi kérdések. E hatások tekintetében a különböző országok szükségszerűen eltérnek egymástól, ami még bonyolultabbá teheti az adatok fejlesztők és mások általi felhasználását. Elvileg a beteg beleegyezésének mértékére vonatkozó döntések a potenciális társadalmi haszon vagy jótékonyság és a beteg autonómiája közötti egyensúlyt tükrözik. A betegadatok anonimitása szintén fontos, de összetett szempont, és ha nem tartják meg, akkor ez is kockázatot jelent. Az adatokkal kapcsolatos döntések meghozatalakor figyelembe kell venni a lehetséges károkat, például a diszkriminációt, a biztosítási költségeket és a megaláztatást.

Elfogultság és méltányosság - Az AI-rendszerek akaratlanul is fenntarthatják vagy akár fel is erősíthetik az egészségügyben meglévő elfogultságokat, ami igazságtalan eredményekhez vezethet. A mesterséges intelligencia rendszerek különösen a képzési adatokra támaszkodnak, nem rendelkeznek kontextussal, és nagyobb valószínűséggel mutatnak elfogultságot, ha a mesterséges intelligencia rendszer képzéséhez használt adatok nem reprezentálják azt a betegpopulációt, amelyre a mesterséges intelligencia rendszert alkalmazni fogják. Ez a torzítás a populációk közötti különbségekből adódik, és tükrözheti a nemet, a szexuális irányultságot, az etnikai hovatartozást, a társadalmi, környezeti vagy gazdasági tényezőket. A felhasznált adatok más okokból is tartalmazhatnak eredendő torzításokat, például a mesterséges intelligencia rendszer képzéséhez az adatokat címkéző emberekből származó torzításokat. A különböző szkennelési eszközök és protokollok szintén befolyásolhatják a mesterséges intelligencia fejlesztése során felhasznált adatokat, és előítéleteket okozhatnak.

A mesterséges intelligencia rendszerek és az emberek közötti kölcsönhatás szintén lényeges. Az emberek ismerik a kontextust, és nagyobb valószínűséggel értik meg, ha a mesterséges intelligencia kimenetei nem megfelelőek egy adott klinikai kontextusban, és inkább cselekszenek, minthogy egyszerűen elfogadják a hibás mesterséges intelligencia tanácsokat. Ezzel szemben az automatizálási torzítás az emberek hajlamossága arra, hogy az AI-rendszerek döntéseit előnyben részesítsék az emberi döntésekkel szemben, ami hibákhoz vezethet, ha az AI-rendszer hibás. Ez az automatizálási torzítás fokozódhat, ha a radiológus fáradt, vagy ha a radiológiai személyzet létszáma korlátozott, és ezért korlátozott a kapacitás az AI kimenetének felügyeletére. A betegbiztonságot érintő kockázatok is nagyobbak lesznek, ha autonóm mesterséges intelligencia rendszereket alkalmaznak, vagy ha a mesterséges intelligencia rendszer idővel tovább tanul és alkalmazkodik. Ezekben a helyzetekben arányosan nagyobb szükség van a mesterséges intelligenciával működő rendszerek teljesítményének értékelésére és nyomon követésére.

Kulcsfontosságú nyilatkozat

A mesterséges intelligencia rendszerek képzési adatokra támaszkodnak, hiányzik a kontextus, és nagyobb valószínűséggel mutatnak torzítást, ha a mesterséges intelligencia rendszer képzéséhez használt adatok nem reprezentálják azt a betegpopulációt, amelyre a mesterséges intelligencia rendszert használják.

Átláthatóság és megmagyarázhatóság - Az átláthatóság megköveteli a mesterséges intelligenciával működő rendszerek képességeire és korlátaira vonatkozó egyértelmű információk nyújtását, különösen a rendszerek rendeltetésének célját, azokat a feltételeket, amelyek mellett a rendszerek várhatóan rendeltetésszerűen működnek, valamint a meghatározott cél elérésének elvárt pontossági szintjét. Ez az információ különösen a rendszerek telepítői számára fontos, de az illetékes hatóságok és az érintett felek számára is fontos lehet. Az átláthatóság fogalmának ki kell terjednie arra is, hogy a betegeket tájékoztatni kell a mesterséges intelligencia rendszerek alkalmazásáról.

Számos mélytanuló mesterséges intelligencia rendszer "fekete dobozként" működik, és ebben a környezetben a radiológusoknak és más egészségügyi szolgáltatóknak kevés vagy semmilyen betekintésük nem lehet abba, hogy a mesterséges intelligencia algoritmus hogyan jutott el a következtetéseihez. Bár egyes mélytanuló rendszerek esetében nehéz megvalósítani, a döntések meghozatalának módjára vonatkozó információk rendelkezésre bocsátása nagyobb megértést és bizalmat eredményez a betegek és az egészségügyi szakemberek körében. A definíciók eltérőek, de az átláthatóság, az értelmezhetőség (a mesterséges intelligencia rendszer működésének megértése) és a megmagyarázhatóság (hogyan hoz döntéseket egy mesterséges intelligencia rendszer, és hogyan mutatja be részletesen a kimenetét) kívánatos, de kockázatokkal jár. A vélemények eltérnek, de az átláthatóság, értelmezhetőség és megmagyarázhatóság szükségességét egyensúlyba kell hozni a magánélet elvesztésével, a védett információk elvesztésével és a rosszindulatú támadásokkal kapcsolatos lehetséges károkkal.

A mesterséges intelligencia a klinikai gyakorlatban - Az adatokhoz, a különböző készségekhez és a számítási teljesítményhez való hozzáférés létfontosságú a mesterséges intelligencia rendszerek fejlesztése és telepítése során. Ezek az erőforrások nem egyenlően állnak rendelkezésre, ami a mesterséges intelligenciából származó előnyökhöz való hozzáférés terén egyenlőtlenségeket eredményezhet, amelyek több tényezőből adódnak, többek között a földrajzi elhelyezkedésből, az etnikai hovatartozásból és a pénzügyi források elérhetőségéből. Például az erőforrásokban gazdag országok vagy kórházak fejlettebb mesterséges intelligencia eszközökhöz férhetnek hozzá, mint az erőforrásokban szegény társaik, ami súlyosbítja az egészségügyi egyenlőtlenségeket.

A mesterséges intelligencia bevezetése az egészségügybe megváltoztathatja az orvosok és a betegek közötti dinamikát, ami hatással lehet a betegek bizalmára. Történelmileg a klinikusokat felelősségre vonják, ha az ellátás nem felel meg az elfogadható színvonalnak. Ha mesterséges intelligencia rendszert használnak, és az ellátási standard nem teljesül, a klinikuson kívül az elszámoltathatóság és a felelősség a fejlesztőre és a mesterséges intelligencia rendszert bevezető egészségügyi intézményre is kiterjedhet.

Összeférhetetlenségek akkor is felmerülhetnek, ha radiológusokat, más egészségügyi szakembereket vagy egészségügyi rendszereket alkalmaznak a mesterséges intelligencia rendszereket forgalmazó kereskedelmi egységek, vagy más módon részt vesznek azokban. Az optimális teljesítmény és a betegbiztonság elérése érdekében figyelmet kell fordítani a mesterséges intelligencia rendszerek sikeres integrálására a munkafolyamatokba és más technológiákba, valamint az ilyen rendszereket használók oktatására. Ha jól csinálják, az AI bevezetése a betegek és a nyilvánosság javát szolgálja, és a radiológusok jól teszik, ha szakmai képességeik kihasználásával relevánsak maradnak az AI biztonságos és hatékony bevezetésének előmozdítása érdekében.

Kulcsfontosságú nyilatkozat

A mesterséges intelligenciával kapcsolatos etikai kérdések kezeléséhez technikai megoldásokra, kormányzati tevékenységre, szabályozási felügyeletre és etikai iránymutatásokra lesz szükség, amelyeket az érdekeltek széles körével - köztük klinikusokkal, betegekkel, mesterséges intelligencia fejlesztőkkel és etikusokkal - együttműködve dolgoznak ki.

4. szakasz: Mit kell figyelembe venniük a fejlesztőknek egy új radiológiai AI-eszköz létrehozásakor?

A. Az új termékek klinikai hasznossága

Az új termékeknek javítaniuk kell a meglévő munkafolyamatok minőségét vagy hatékonyságát az elváltozások felismerése, szegmentálása, diagnosztizálása vagy a klinikai eredmények előrejelzése tekintetében. A radiológiai AI-fejlesztők gyakori hibája, hogy a rendelkezésre álló technológiát és adathalmazt tükröző megoldásokat fejlesztenek, nem pedig olyanokat, amelyek klinikai hasznossággal támogatják a meglévő munkafolyamatokat. A társaságok által kifejlesztett források, mint például az ACR DSI Define-AI directory, gyakran jó kiindulópontként szolgálnak annak biztosítására, hogy a kifejlesztett technológia megfeleljen a valódi klinikai igényeknek. Létező használati esetreferencia hiányában, vagy olyan alkalmazás hiányában, amely nem egy meglévő alkalmazás közvetlen továbbfejlesztése, a fejlesztőknek a lehető legkorábban be kell vonniuk a klinikusokat a tervezési és fejlesztési folyamatba, hogy betekintést nyerjenek a javaslatok megvalósíthatóságába és gyakorlatiasságába, még jóval a jelentős idő- és fejlesztői erőforrások befektetése előtt.

Kulcsfontosságú kijelentés - Az új termékeknek inkább a kielégítetlen klinikai szükségleteket kell megcélozniuk, mintsem a meglévő technológiára és adathalmazokra összpontosítaniuk.

B. A meglévő klinikai/radiológiai eszközökhöz képest való felsőbbrendűség

A meglévő klinikai eljárásokkal szembeni felsőbbrendűség bizonyítása kihívást jelenthet a fejlesztők számára, különösen azok számára, akiknek korlátozott klinikai tapasztalatuk van az adott területen. A már létező nyílt tudományos versenyek által támogatott megoldások esetében, ahol egyértelmű teljesítménymutatókat határoztak meg, és a versenyre jelentkezők rangsorát vezetik, általában könnyebb bizonyítani a versenyképesség egyenértékűségét vagy felsőbbrendűségét. Ez különösen az éves RSNA- és MICCAI-konferenciákon megrendezett mesterséges intelligencia-kihívások hosszú sorában figyelhető meg. Azokban a helyzetekben, amikor ilyen nyílt adatok nem állnak rendelkezésre, a fejlesztőknek meg kell határozniuk a klinikai alapteljesítményt, és össze kell hasonlítaniuk az AI teljesítményét a meglévő vagy jóváhagyott szoftverekkel, vagy több radiológus értékelőből álló kontrolladatokkal. A jól megtervezett, több leolvasó készülékkel végzett diagnosztikai pontossági vizsgálatok a mesterséges intelligencia megoldások felsőbbrendűségéről szóló jelentések gyakori módszere, bár ezek hatékony elvégzése nehéz és költséges lehet. Ha az emberi értékelőket mesterséges intelligencia segíti, az algoritmus különböző használati módjai, például az első értékelés, a párhuzamos értékelés, a másodleletezés vagy a triázs módok befolyásolhatják a relatív teljesítmény elemzését.

C. Radiomika, megmagyarázhatóság és átláthatóság

A mesterséges intelligencia alkalmazások bizonyos osztályai különleges kihívást jelentenek a modellek értelmezhetősége szempontjából. A radiomika nagyszámú jellemzőnek az orvosi képekből való kinyerésére utal, adatjellemző algoritmusok segítségével, amelyek a pixelek intenzitását, a pixelek közötti kapcsolatokat, alakzatokat és textúrákat írják le. E jellemzők közül sok nem intuitív, vagy nem könnyű megfeleltetni a szubjektív vagy klinikai képi leleteknek. A mesterséges intelligenciamodellek fekete doboz jellegével kapcsolatban sok megjegyzés született, a korai erőfeszítések a hőtérképek és a kiemeltség vizualizációjára összpontosítottak; egyes kutatók a diagnózisok értelmezhetőségének javítása érdekében a vizualizáció és a generált szöveg kombinációját szorgalmazták. A hagyományos orvosbiológiai kutatásból levont tanulságok rendkívül fontosak, és azokban a helyzetekben, ahol a modell átláthatósága és magyarázhatósága gyenge, a teljesítmény empirikus bizonyításának magasabb szintű követelményeire lehet szükség, beleértve a külső vagy többközpontú tesztadatokat a modell általánosíthatóságának bizonyítására, valamint a prospektív, valós körülmények között végzett értékelést, amelyet olyan klinikai környezetben alkalmaznak, amely leginkább hasonlít ahhoz a klinikai környezethez, amelyben a terméket valószínűleg a legnagyobb valószínűséggel alkalmazzák majd.

5. szakasz: Milyen információkat kell kérniük a szabályozóknak a fejlesztőktől a mesterséges intelligencia szoftverek klinikai felhasználásának jóváhagyása előtt?

Kulcsfontosságú kijelentés

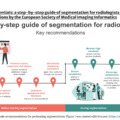

A jóváhagyás előtt a szabályozó hatóságoknak a mesterséges intelligenciát alkalmazó szoftverek fejlesztőitől a vállalatra, a klinikai felhasználásra, a megvalósításra, a termékfejlesztésre, a demonstrációra, a költségekre és a publikációkra vonatkozó információkat kell kérniük.

A mesterséges intelligencia megoldások általában a megoldás teljesítményére vonatkozó becsléseket mutatnak be, a retrospektív és prospektív validációs kísérleti eredmények kombinációjával, amelyeken a funkcióra vonatkozó kijelentéseik alapulnak.

A szabályozóknak nagy figyelmet kell fordítaniuk annak biztosítására, hogy a közölt információk megfeleljenek a legmagasabb szintű gyakorlati előírásoknak; a vizsgálatoknak ideális esetben meg kell felelniük a többszörösen elfogadott tudományos szabványokban meghatározott kritériumoknak. A gyengébb minőségű bizonyítékok gyakran jelentős hiányosságokat tartalmaznak a jelentett információkban, és csak részben felelnek meg ezeknek a standard kritériumoknak. A megoldások teljesítményéről szóló jelentésekben két gyakori hiba a következő: a várt teljesítménytartomány jelentésének elmulasztása - a gyengébb minőségű megoldások gyakran egyetlen összefoglaló pontossági adatot közölnek -, valamint a konkrét hibaállapotok és hibák jelentésének elmulasztása, a gyengébb minőségű megoldások szelektíven kiemelik a rendszereik által felállított legjobb diagnózisokat. A szélesebb értelemben vett mesterséges intelligencia-biztonsági közösségben nagy teret hódítanak a modellkártyák vagy rendszerkártyák, amelyekben a korlátozások, hibák és torzítások mélyreható elemzéseit kifejezetten jelentik, gyakran teljesen elkülönítve a rendszer teljesítményének elsődleges jelentésétől. A nyilvánosság ilyen szintű átláthatóságát a szabályozóknak határozottan ösztönözniük kell a mesterséges intelligencia biztonságának fokozottabb kultúrája érdekében, és a beadványok minőségének értékelésénél elsődleges szempontnak kell lennie.

Bár a klinikai kockázati modellek földrajzi és történelmi precedensek alapján eltérőek, határozottan úgy véljük, hogy bármely szabályozási modellnek egyértelmű kategóriákat és határokat kell meghúznia a tanácsadó, félautomata és automatizált rendszerek között, és a nagyobb fokú autonómia esetén mélyebb bizonyítékbázisra és valós tapasztalatokra van szükség. A klinikai hivatkozások gyakran idézik az autonóm vezetésre javasolt automatizálási skálákat, például a SAE J3016 vezetésautomatizálási szinteket. Több kísérletet is javasoltak a radiológiai munkafolyamatok automatizálásának analóg szintjei kialakítására. Az orvostechnikai eszközökre vonatkozó hagyományos szabályozási keretek túlnyomórészt a megfigyelő vagy terápiás eszközökre összpontosítottak, amelyek a közelmúltig nagyon ritkán rendelkeztek autonóm működésre alkalmas funkciókkal. Az általános mesterséges intelligencia szakirodalom tele van a felügyelet nélküli döntéseket hozó mesterséges intelligencia negatív és gyakran váratlan káros hatásaira vonatkozó példákkal. A klinikai orvosi képalkotás során szükséges döntések betegre gyakorolt hatása, még a stabilitás vagy a normalitás megállapítása is, gyakran drámai közvetlen hatással van a betegellátásra, ami gyaníthatóan még egy ideig emberi társfelügyeletet igényel.

A szabályozó hatóságoknak különösen oda kell figyelniük arra, hogy a megoldásoknak legyen egy kifejezett, a forgalomba hozatal utáni minőségbiztosítási tervük. Ennek fontossága több szempontból is jelentős, de főként a koncepció sáltal okozott problémákra vonatkozik, amelyek a betegpopuláció változásai vagy esetenként az AI-szoftverek egymást követő új verzióinak frissítése miatti különbségek miatt merülnek fel. A gyakorlatban ez a mesterséges intelligencia modell prospektív teljesítmény-ellenőrzését jelentheti, például a diagnosztikai események gyakoriságának hónapról hónapra történő jelentős eltéréseinek nyomon követését, riasztásokkal, ha a normál határértékeket túllépik, vagy egy olyan kontrollminta-megközelítést, ahol a tesztesetek egy állandóan fenntartott, visszatartott példakészletét rendszeresen értékelik az algoritmussal annak biztosítása érdekében, hogy az ismert nehéz vagy határeseteknél ne legyenek jelentős eltérések. Legalább a váratlan hibáknak a szállító felé történő egyértelmű jelentési eljárását kell kialakítani, a felelős kapcsolattartó személy megnevezésével, és azt a klinikai végfelhasználók számára könnyen hozzáférhetővé kell tenni.

6. szakasz: Mit kell figyelembe venniük az AI-eszközök vásárlóinak, amikor az AI-eszközök gyakorlati bevezetését fontolgatják?

A mesterséges intelligencia alkalmazások klinikai gyakorlatban történő bevezetésének mérlegelésekor számos kulcsfontosságú szempontot kell figyelembe venni annak érdekében, hogy valamennyi érintett fél számára fenntartható előnyöket biztosítsanak. Amint azt az előző szakaszban leírtuk, az FDA, az EMA vagy az ezekkel egyenértékű ügynökségek hatósági jóváhagyása igazolja, hogy az orvostechnikai eszközök (beleértve az AI-eszközöket is) megfelelnek a vonatkozó előírásoknak, és az eszköz kockázati kategóriája alapján megfelelőségértékelésen mentek keresztül. Ez a tanúsítás önmagában azonban nem feltétlenül garantálja a sikeres bevezetést a klinikai munkafolyamatokba. Többek között ezért kulcsfontosságú, hogy a potenciális vásárlók a következő szempontokat vegyék figyelembe:

- Mi a mesterséges intelligencia tervezett felhasználása, kinek származik a legnagyobb haszna a használatából, milyen kockázatokkal jár a használata, és mi a potenciális gazdasági hatása?

- Hogyan integrálják a mesterséges intelligencia eszközt az intézmények munkafolyamataiba, és hogyan ellenőrizhetők és felügyelhetők a kereskedelmi állítások?

- Hogyan kell képezni a felhasználókat, és milyen pszichológiai hatásokat kell figyelembe venni az ember és az AI közötti interakció tekintetében?

- Az FDA (vagy más ügynökség) jóváhagyási/engedélyezési adatai tükrözik-e a helyi adatok pontosságát? A helyi adatok pontossága elegendő-e az adott intézményben történő felhasználáshoz, és a felhasználók elfogadják-e a mesterséges intelligencia eredményeit, és így részt vesznek-e azokban?

Használati előnyök, kockázatok és költségek

Ahhoz, hogy bármilyen mesterséges intelligencia eszközt sikeresen integrálni lehessen a klinikai gyakorlatba, az érdekelt feleknek először egyértelműen meg kell határozniuk a fejlesztésre szoruló területeket, és meg kell határozniuk a vonatkozó kulcsfontosságú teljesítménymutatókat. Az AI-eszköz integrálása ezután az intézmény számára kitűzött cél elérése érdekében kidolgozott nagyobb stratégia részét képezheti. Alternatívaként az is előfordulhat, hogy egy adott, a szállító által javasolt mesterséges intelligencia eszköz olyan területen kínál lehetőséget az intézmény szolgáltatásainak minőségének javítására, amelyet korábban nem vettek figyelembe. A 4A. szakaszban vázoltak szerint mindkét esetben alapvető fontosságú annak meghatározása, hogy az eszköz megoldja-e az intézmény valós, konkrét problémáját; az eszközök megoldások, és egy nem létező problémára adott megoldásnak nincs értéke. Vegyük figyelembe azt is, hogy a különböző intézményeknek különböző problémáik vannak; egy eszköz, amely az egyik csoport számára értékes, nem biztos, hogy egy másik csoport számára értékes.

Ahhoz, hogy egy mesterséges intelligencia eszköz pozitív hatása mérhető legyen, objektív és számszerűsíthető célokat kell kitűzni. Hasznos lehet mérlegelni, hogy az AI-eszköz várhatóan az esetek vagy betegek mekkora hányadára lesz hatással, és hogy az egyes esetekre vagy betegekre gyakorolt hatás várhatóan mekkora lesz. A beszerzőknek tisztában kell lenniük azzal, hogy az AI-eszközök kedvezményezettje nem mindig csak a radiológus vagy a radiológiai osztály kell, hogy legyen. Ideális esetben a szolgáltatást igénylő pácienstől kezdve az adott intézményen át a szélesebb társadalomig minden érintett fél profitálhat abból, ha a mesterséges intelligenciát sikeresen alkalmazzák a klinikai munkafolyamatokban. Felhasználási terület lehet például a mesterséges intelligencia mint támogató eszköz a nagy volumenű radiológiai szűrővizsgálatokban (pl. mammográfia). Ebben az esetben a betegek számára az előnyök közé tartozhat az emlőrák korábbi és jobb felismerése, ami jobb általános kimenetelhez vezet, míg a radiológusok számára a termelékenység növekedése, egy további "biztonsági háló" rendelkezésre állása vagy a beteggel való interakcióra fordítható idő növekedésének lehetősége. A termelékenység és a szolgáltatás minőségének javulása mellett, amely pozitívan hat az intézményre, potenciálisan hozzájárulhat a költségek csökkentéséhez, míg a társadalom szélesebb rétegei számára az általános egészségügyi költségekre és a népesség egészségére gyakorolt pozitív hatások képzelhetők el. Ilyen hatások várhatóak más, általánosan javasolt felhasználási esetekben is, mint például a nagy érelzáródások felismerése vagy más időérzékeny helyzetekben. Más alkalmazások, például a szervezeti mesterséges intelligenciát támogató eszközök vagy a még inkább kutatásra épülő alkalmazások (például a mesterséges intelligenciával támogatott opportunista szűrés) esetében azonban az előnyök nem biztos, hogy ilyen könnyen meghatározhatók. A helyi körülményektől és a fennálló egészségügyi rendszertől függően az ilyen potenciális előnyöket gondosan mérlegelni kell a közvetlen és közép- vagy hosszú távú gazdasági hatásukkal szemben. A tervezett mesterséges intelligencia integráció életképességének biztosítása érdekében beruházás megtérülési és költség-haszon elemzéseket kell tervezni és végezni. Az egészségügyi rendszertől függően kritikus fontosságú lehet egy életképes fizetési mechanizmus létrehozása a mesterséges intelligencia alkalmazására. Azok az AI-modellek, amelyek elsősorban a fizetős kórházak vagy járóbeteg-képalkotó központok számára jelentenek hasznot, a megtérülést a tartózkodási idő csökkenésével, a sürgősségi osztályon való átfutás javításával, a nyomon követést és/vagy kezelést igénylő leletek mennyiségének növelésével, a képalkotó vizsgálat elvégzéséhez szükséges idő csökkentésével és a radiológiai osztály működésének javításával bizonyítják. A radiológiai praxis számára egyéb lehetséges előnyök közé tartozik a mentális fáradtság csökkenése, a radiológusok jobb toborzása és megtartása, valamint az orvosi műhiba felelősség csökkenése, bár ezek általában additív jellegűek, mivel általában nem fedezik a mesterséges intelligencia költségeit.

Végül pedig a mesterséges intelligencia rendszer bevezetésével és használatával kapcsolatos potenciális költségek (mind a tőke-, mind az ismétlődő költségek) és kockázatok alapvető összetevői minden beszerzési elemzésnek és döntésnek. A kockázatértékelést részben megkönnyítheti a kockázati mátrix és a gyártók által a szabályozási dokumentációban megadott kockázat-haszon elemzés megtekintése. Előfordulhat azonban, hogy egyes kockázatokkal nem foglalkoznak az ilyen szabályozási dokumentációban, vagy azok csak a használat során válnak nyilvánvalóvá. A költségek legnyilvánvalóbb összetevője a szállítónak fizetett licencköltségek, de ezek általában csak kis részét képezik a teljes tulajdonlási költségnek. A költségek további forrásai közé tartoznak a szerződéskötési és jogi megállapodások, a meglévő rendszerekkel való integrációval kapcsolatos informatikai erőfeszítések és szakmai szolgáltatások, a felhasználók és rendszergazdák képzése, a mesterséges intelligencia működtetéséhez szükséges infrastruktúra, valamint a folyamatos karbantartás és felügyelet.

A megalapozott döntés meghozatalához további lényeges tényezők közé tartozik a szállító megbízható partnerként való értékelése, a szállító kitartása a korlátozott fizetőeszköz-visszatérítéssel járó versenykörnyezetben (ami még fontosabb a mesterséges intelligencia szállítói konszolidáció korában), az optimalizált modell árazása, valamint a termékvásárláson túli együttműködési lehetőségek, például a közös fejlesztés és a termék viszonteladása.

A kockázat egyik legfontosabb összetevője annak megértése, hogy az algoritmus teljesítményjellemzői milyenek lehetnek abban a környezetben, amelyben használni fogják. A használatban lévő hibaarány jelentősen eltérhet a tesztelés során jelentettől, különösen akkor, ha a bemeneti adatok jellemzői vagy eloszlása (pl. a képalkotó berendezés gyártója, a vizsgálati protokollok, a betegek demográfiája, a betegségek gyakorisága, a társbetegségek) eltérnek a tesztadatoktól. Ideális esetben a bevezetést fontolgató egyes helyszínek a saját helyi adataik alapján statisztikailag szigorúan értékelik a teljesítményt (ennek az értékelésnek a módszerét az alábbi, a klinikai értékelésről szóló szakasz mutatja be). A gyakorlatban ez nem biztos, hogy megvalósítható. Legalább a helyi adatok jellemzőit össze kell hasonlítani a vizsgálati adatok jellemzőivel (tipikus példa lehet, ha egy modellt csak egy gyártó MRI-berendezésén teszteltek, de egy másik gyártó által gyártott berendezésen fogják használni). Ha ezek hasonlóak, a bejelentett teljesítménymutatókra bizonyos bizalommal lehet támaszkodni; ha nem (pl. egy csak felnőtteken tesztelt algoritmus, amelyet egy gyermekkórházban off-label használatra terveznek), akkor nagy óvatossággal kell eljárni, ha egyáltalán van ilyen. A hibák gyakorisága, amely fogalmilag a teljesítmény fordítottja, nem a kockázat végső szava, mivel a különböző hibák különböző kockázatokat jelentenek. Figyelembe kell venni a várható hibák kimutathatóságát. Vagyis minden egyes hiba esetében mekkora annak a valószínűsége, hogy a munkafolyamatban részt vevő emberek észreveszik, hogy a mesterséges intelligencia hibás kimenetet produkált? Minden egyes észlelt hiba esetében mekkora a valószínűsége annak, hogy a hibát kijavítják? Végül, ha egy hibát nem észlelnek vagy nem javítanak ki, milyen várható hatása van a betegekre vagy más érdekeltekre? A hibák gyakoriságának, észlelhetőségének, javíthatóságának és hatásának együttes figyelembevétele keretet biztosít az algoritmikus hibák közvetlen kockázatának értékeléséhez. E kockázatok folyamatos nyomon követését a 7. szakasz tárgyalja.

A kockázat másik kulcsfontosságú összetevője az AI-eszköznek a radiológus teljesítményére gyakorolt hatása. Ha egy feladat elvégzése egy automatizált eszközre támaszkodik, az a radiológusok képzettségének csökkenéséhez vezethet az eszköz által átvett feladathoz. Ez a kockázat különösen problematikus, ha a radiológustól elvárják, hogy az eszköz meghibásodása esetén manuálisan végezze el a feladatot, de lehet, hogy már nem elég képzett ahhoz, hogy ezt megfelelően elvégezze. A felhasználó túlzott vagy alulbízása szintén csökkenti a radiológus és a mesterséges intelligenciamodell kombinált kimenetének pontosságát, és ezt a 8. szakaszban tárgyaljuk tovább.

A kockázat utolsó szempontja, amelyet figyelembe kell venni, az a lehetőség, hogy a mesterséges intelligencia létrehozhatja vagy súlyosbíthatja az egészségügyi ellátásban mutatkozó egyenlőtlenségeket. A mesterséges intelligencia különösen hajlamos erre, mivel általában klinikai archívumokból származó retrospektív adatokon képzik ki, és ezek az adatok társadalmunk jelenlegi és történelmi egészségügyi egyenlőtlenségeit és egyenlőtlenségeit tükrözik. A mesterséges intelligencia képzése egy költségfüggvény minimalizálásának matematikai folyamata, amely etika és erkölcs nélkül zajlik. Ezért a mesterséges intelligencia tanulhat a képzési adatokba ágyazott egyenlőtlenségekből és egyenlőtlenségekből, és a végrehajtás során állandósíthatja ezeket. Nincs könnyű vagy egyenes eljárás ezen elfogultságok átfogó azonosítására, de orvosként és adattudósként ránk hárul, hogy gondolkodjunk, keressük és enyhítsük ezeket az elfogultságokat; ha ezeket a kérdéseket nem tesszük fel, akkor minden bizonnyal megválaszolatlanok maradnak.

Integráció, ellenőrzés és felügyelet

A várható előnyök és célok meghatározása, a költség-haszon elemzés elvégzése és a potenciális kockázatok felmérése után megtervezhető a kiválasztott mesterséges intelligencia eszközök integrálása. A helyi IT-infrastruktúrától és -politikáktól függően a vásárlók különböző technikai integrációkat vehetnek fontolóra - akár helyi telepítésként, helyben dedikált számítási erőforrásokkal, akár felhőalapú szoftver mint szolgáltatás (SaaS) modellként. Mindkét típusú telepítés esetén a DICOM és a HL7 adat-összehangolás létfontosságú szerepet játszik annak biztosításában, hogy a megfelelő vizsgálat megfelelő sorozatának megfelelő szeleteit a megfelelő pácienshez, a megfelelő környezetben, optimális időben küldjék el a megfelelő mesterséges intelligenciához. A robusztus integráció eléréséhez elengedhetetlen az adatok tartalmának megértése és strukturálása. Sajnos a DICOM metaadatokra való hagyatkozás gyakran nem elegendő a vizsgálatok és sorozatok neveinek nagyfokú változékonysága és labilis jellege miatt, valamint amiatt, hogy a DICOM fejlécek hiányosak lehetnek. Megbízhatóbb megoldás a képalkotó mesterséges intelligencia használata az adattartalom meghatározására a vizsgálatok és sorozatok szintjén, és ennek felhasználása a kimeneti adatok összehangolásához. A mesterséges intelligenciájának használata annak meghatározására, hogy mely testrészek vannak az egyes képeken, és hogy intravénás kontrasztanyagot adtak-e be, a két leghasznosabb kiegészítés. A mesterséges intelligencia rendszerből történő adatszervezéshez olyan intelligens rendszerre van szükség, amely képes a különböző munkafolyamatok megkönnyítésére a mesterséges intelligencia eredményeinek megértésétől függően. A legtöbb jelenlegi megvalósítás csak az AI-eredményeket küldi el a képarchiváló és kommunikációs rendszerbe (PACS). Ez a korlátozott integráció nem csak azt teszi lehetővé, hogy a beutaló orvosok vizualizálják az AI-eredményeket, ami nem feltétlenül optimális, ha ezek az orvosok nem kaptak képzést az AI-modell részleteiről és pontosságáról, hanem bizonyítottan növeli az automatizálási előítéleteket a radiológusok körében. Továbbá a PACS jelenleg korlátozott módokat kínál az AI-eredmények integrálására, és a legtöbb esetben a radiológus nem tudja módosítani az AI-eredményeket a PACS-ban. Az AI-eredmények kezelésének és integrációjának optimalizálása érdekében a PACS-nek lehetővé kell tennie a radiológus számára, hogy interakcióba lépjen az AI-eredményekkel és módosítsa azokat, és ha az eredmények megváltoznak, felhatalmazza az AI-t az új kimenet azonnali újrafeldolgozására. Ezen túlmenően a frissített mesterséges intelligenciaeredményt el kell juttatni a mesterséges intelligencia szállítójának, hogy az felhasználható legyen a jövőbeli modellfejlesztéshez. Az ilyen típusú interakciót megkönnyíti a felhő-natív környezet, ahol a PACS és a mesterséges intelligencia modellek egyaránt megoszthatják a radiológiai adatokat és a mesterséges intelligencia eredményeit. Emellett a felhő-natív rendszerekben a felhő-natív rendszerek alapvető műszaki szempontok közé tartozik az AI-eredmények és a radiológus visszajelzések elfogadásának és tárolásának képessége, az adatbiztonság optimalizálása és az AI pontosságának folyamatos ellenőrzése.

Bármilyen integrációról legyen is szó, ideális esetben az AI-eszközöknek jól integrálódniuk kell a szokásos klinikai munkafolyamatokba és információs rendszerekbe, hogy a felhasználóknak ne kelljen az alkalmazások között váltogatniuk. Egy nemrégiben közzétett felmérés szerint a többletmunkaterheléssel kapcsolatos aggodalmak voltak az egyik fő oka annak, hogy a válaszadók nem kívánnak mesterséges intelligencia eszközöket beszerezni klinikai gyakorlatukhoz. Ugyanez a felmérés megállapította, hogy a másik fő aggodalom az volt, hogy a mesterséges intelligencia rendszer nem fog olyan jól teljesíteni, mint ahogyan azt hirdetik. Ez az aggodalom fontos, és nem szabad figyelmen kívül hagyni. Természetesen a gyártók a hatósági jóváhagyás során elvégezték az adott mesterséges intelligencia-eszközök tesztelését és minőségbiztosítását, de a vásárlóknak fontolóra kell venniük a mesterséges intelligencia teljesítményének validálását egy helyi adathalmazon, és szükség esetén a klinikai gyakorlatban történő bevezetés előtt módosítaniuk kell a paramétereket. Ezt a folyamatot meg kell ismételni minden olyan esetben, amikor a mesterséges intelligencia szoftverben vagy a mesterséges intelligenciával együtt használt berendezésekben releváns változtatásokat hajtanak végre. Egy kereskedelmi forgalomban kapható emlőszűrő mesterséges intelligenciamodell példájában a mesterséges intelligencia eszköz frissítése lényegesen eltérő visszahívási arányt eredményezett, ami a döntési küszöbérték újrakalibrálását tette szükségessé a klinikailag elfogadható diagnosztikai pontossággal történő további használat biztosítása érdekében. Ezek az eredmények rávilágítanak arra, hogy nem lehet magától értetődőnek tekinteni, hogy a forgalomba hozatal előtti publikációkban állított diagnosztikai teljesítmény a klinikai használat során hasonló és stabil teljesítményt jelent, és hangsúlyozzák az alkalmazott mesterséges intelligencia rendszerek folyamatos, forgalomba hozatal utáni felügyeletének szükségességét. Ennek pontos megközelítését az érintett szabályozó szervek jelenleg vitatják meg. Például az Egyesült Királyság gyógyszer- és egészségügyi termékeket szabályozó hatóságának (MHRA) a gyártóknak szóló útmutatója a szoftvert mint orvostechnikai eszközt érintő nemkívánatos eseményeknek a vigilancia-rendszer keretében történő bejelentéséről részletezi azokat a különböző körülményeket, amelyek esetén egy nemkívánatos eseményt jelenteni kell - többek között "(nem) sikerült azonosítani az akut stroke-hoz kapcsolódó klinikailag releváns agyi képleleteket" és "(az MRI-képek) anatómiai és patológiai struktúrák megjelenésének romlása". Hasonlóképpen, az FDA által javasolt, a mesterséges intelligencia/gépi tanulás (AI/ML) alapú, orvostechnikai eszközként használt szoftverek módosítására vonatkozó szabályozási keretrendszer elvárná a gyártóktól, hogy "kötelezzék el magukat az átláthatóság és a valós teljesítmény nyomon követésének elvei mellett", amikor frissítik termékeiket. Az AI-eszközök klinikai gyakorlatban történő bevezetésében érdekelt feleknek ezért meg kell ismerniük a klinikai értékelés vonatkozó módszereit és mérőszámait, és stratégiákat kell kidolgozniuk a teljesítményre vonatkozó állítások ellenőrzésére az eszköz bevezetése előtt, és folyamatosan nyomon kell követniük a teljesítményt a rutinszerű használat során. Ez különösen fontos, mivel a korábban említett felmérés szerint a válaszadók nagy többsége nem értékelte rendszeresen a mesterséges intelligencia diagnosztikai pontosságát. A forgalomba hozatal utáni nyomon követést részletesebben a 7. szakasz tárgyalja (alább).

Ember-AI interakció

A technikai teljesítmény részletei és az AI-eszközök gyakorlati munkafolyamatok radiológiai integrációja mellett nem szabad alábecsülni a nehezen mérhető emberi tényezők fontosságát sem. A mesterséges intelligencia kétségtelenül lenyűgöző fejlődést ért el, és számos felhasználási esetben az emberi leolvasókéhoz hasonló diagnosztikai teljesítményt tud elérni. Ez különösen az emlőrákszűrés összefüggésében mutatkozott meg. A fentiekben tárgyaltak szerint azonban számos tényező befolyásolhatja a mesterséges intelligencia eszközök technikai diagnosztikai teljesítményét a klinikai gyakorlatban. Bár felmerült, hogy az emberi olvasó és az AI-eszköz kombinációja segíthet az általános diagnosztikai pontosság növelésében azáltal, hogy az ember felfedezi az AI által elkövetett hibát, vagy fordítva, a legújabb tanulmányok megkérdőjelezik ezt a feltevést, és rámutatnak, hogy tovább kell vizsgálni azokat a pszichológiai jelenségeket, amelyek az ember és az AI közötti interakcióban torzíthatják a döntéshozatalt. Jól ismert, hogy az automatizálási torzítás - az automatizált rendszerekre, például az AI-alapú döntéstámogató eszközökre való túlzott támaszkodásra való hajlam - befolyásolhatja az emberi olvasókat, és negatívan befolyásolhatja a felügyelet gyakorlásának képességét. Nemrégiben egy mammográfiára összpontosító vizsgálat megállapította, hogy még a legtapasztaltabb leolvasók is mutatták ezt az előítéletet egy kísérleti környezetben, és jelentősen rosszabb teljesítményt nyújtottak, amikor egy állítólagos AI-rendszer rossz BI-RADS-kategóriát javasolt. Ezzel szemben megfigyelhető az algoritmikus averziónak nevezett ellentétes hatás is - amikor az információt a döntéshozatali folyamatban kizárólag az alapján utasítják el, hogy az mesterséges intelligencia által generált. Egy nemrégiben végzett vizsgálat kimutatta, hogy a radiológusok és más orvosok kevésbé megbízhatónak ítélték ugyanazt a mellkasröntgenfelvétellel kapcsolatos információt, ha az látszólag egy mesterséges intelligencia rendszerből származott, mint ha emberi szakértőtől. Ezeket a kérdéseket tovább bonyolítja az a tény, hogy az ember és az AI közötti interakciót befolyásolhatják a felhasználói felület (UI) kialakításának részletei. Például, bár sok radiológus a tüdőgócok felismeréséhez a képátfedéseket részesítette előnyben, azt találták, hogy a felhasználói felületnek ez a konfigurációja nem javította az olvasó teljesítményét, míg a csak szöveges felhasználói felületet tartalmazó minimalista beállítás igen. Hasonlóképpen, az endoszkópia során a tekintetet értékelő vizsgálat megállapította, hogy a polipok felismerésére szolgáló számítógépes rendszer használata az endoszkópos videók kiértékelése során jelentősen csökkentette a szemmozgást, és növelte a normális nyálkahártya téves értelmezését. Ezek az eredmények rávilágítanak arra, hogy további oktatásra van szükség e témákban a felhasználók és az érintettek tudatosságának növelése érdekében, valamint a mesterséges intelligencia biztonságos és sikeres bevezetése érdekében a klinikai rutinban. Az ember és az AI közötti torzítás mérséklésének lehetőségeit a 8. szakasz tárgyalja. Ezen a területen további célzott kutatásokra van szükség ahhoz, hogy megbízható bizonyítékot szolgáltassunk az ember és az AI közötti interakció legjobb kialakításának módjáról.

Klinikai értékelés

Bár az FDA vagy más érintett hatóság jóváhagyási/engedélyezési adatai nyújtanak némi betekintést, a mesterséges intelligencia modell tesztelése helyi adatokon, a gyakorlatban használt helyi rendszerekkel és munkafolyamatokkal elengedhetetlen a pontosság és a relevancia biztosításához, amikor a modellt bevezetik. Bár a helyi értékelést az adott mesterséges intelligenciamodellhez és a helyi erőforrásokhoz kell igazítani, a 3. táblázat olyan taktikákat vázol fel, amelyek segíthetnek eldönteni, hogy egy adott modell releváns-e a helyi gyakorlat szempontjából, és megfelelő pontossággal működik-e a helyi adatokon.

A klinikai pontosság értékelésének folyamata hatékonyan elvégezhető, és nem igényel modell implementálást a klinikai munkafolyamatba. Az első lépés a mesterséges intelligenciamodell helyi adatokon nyújtott teljesítményének összehasonlítása a szabályozó hatóság dokumentációjával, különösen a pontosság értékelése a radiológus elfogadottságának és a mesterséges intelligencia eszközzel való elkötelezettségének szemszögéből. Ezért a radiológusra vonatkozó paraméterek, beleértve a betegség előfordulásának pozitív és negatív prediktív értékeit, fontosabbak, mint az általános pontosság, a görbe alatti terület (AUC) vagy az érzékenység/specifikusság. Másodszor, számítsa ki a "fokozott észlelési arányt", vagyis azt az optimalizált észlelési arányt, amelyet a radiológus és az AI valódi pozitív eredményeinek kombinált észlelésével lehetne elérni. Harmadszor, lenyűgöző, vagy "WOW eseteket" kell azonosítani, hogy a felhasználók és az érdekeltek számára bemutassák az AI modell értékét. Negyedszer, a mesterséges intelligencia hamis pozitív és - ha lehetséges - hamis negatív esetek kategorizálása meghatározhatja a radiológusok elvárásait, és javíthatja a tökéletlen mesterséges intelligenciamodell elfogadottságát (minden mesterséges intelligenciamodell tökéletlen). Végezetül az összes eredményt felül kell vizsgálni annak megállapítása érdekében, hogy az AI-modell méltó-e a klinikai alkalmazásra.

A döntés végső soron a pozitív prediktív érték (amely nagymértékben függ a betegség gyakoriságától) és a "WOW" esetek értéke és száma közötti egyensúlyon múlik. A radiológusok hajlandóbbak elfogadni a hamis pozitív eredményeket, ha a modell olyan patológiát is azonosít, amely lenyűgözi a radiológust, vagy hozzáadott értéket jelent a beteg vagy más érdekelt fél számára. A betegség gyakorisága szintén nagy hatással van a downstream modell elfogadására. Az alacsony betegségprevalenciájú mesterséges intelligenciamodellek számos hamis pozitív eredményt produkálnak, ami korlátozza a felhasználói elfogadottságot. A mesterséges intelligenciamodellnek bemutatott betegcsoportban a betegség előfordulási gyakorisága módosítható a beteg képalkotási helyeinek megfelelő kiválasztásával, például sürgősségi osztály, fekvőbeteg- vagy járóbeteg-ellátás. Ezért egyes AI-modelleket a vizsgálatok egy részhalmazán lehet alkalmazni, mivel az adott vizsgálati részhalmazban a betegség előfordulási gyakorisága a kiindulási értékhez képest megnövekedett. Például a mellkas röntgenfelvételen (CXR) látható pneumothorax (PTX) gyakoribb a fekvőbetegeknél, mint az átlagpopulációban. Ha a PTX AI modellt csak a fekvőbetegek CXR-felvételeire korlátozzuk, kevesebb hamis pozitív eredményt kapunk, és a radiológusok a pontosság szempontjából nagyobb valószínűséggel fogadják el.

A fenti 5 lépéses klinikai értékelésből származó információk felhasználása a radiológusoktatásban, a változáskezeléssel együtt, elengedhetetlen a felhasználói elvárások meghatározásához a mesterséges intelligenciamodell bevezetése előtt. A helyi AI-bajnok jelentős szerepet játszik az AI elfogadásának előmozdításában a radiológusok körében. Végezetül a felhasználók folyamatos oktatása az AI használatának teljes életciklusa alatt, valamint a radiológus AI használatának és a radiológus és az AI kombinált pontosságának nyomon követése alapvető fontosságú az optimális betegellátás biztosításában.

7. szakasz: Mit kell szem előtt tartani a mesterséges intelligencia eszközök hosszú távú stabilitásának és biztonságának biztosításához?

A mesterséges intelligencia modellek klinikai használatban való teljesítményének nyomon követése fontos tényezője a mesterséges intelligencia biztonságos és hatékony alkalmazásának a klinikai gyakorlatban, és ez az Egyesült Államok Élelmiszer- és Gyógyszerügyi Hatóságának (FDA) a teljes termékéletciklusra vonatkozó megközelítésének (1. ábra) egyik fő jellemzője a szoftver mint orvosi eszköz (SaMD) szabályozásában, amely a képalkotó mesterséges intelligenciát is magában foglalja. A végfelhasználóknak számolniuk kell azzal, hogy a statikus (más néven "zárolt algoritmusok") AI-modellek teljesítménye idővel csökkenhet a helyi bemeneti adatok változása, a képalkotó berendezések vagy protokollok változása, a forráskép paramétereit, például a zajszintet befolyásoló képfelvételi szoftverfrissítések, vagy a betegpopuláció és a demográfia természetes változásai miatt. Ezért a mesterséges intelligencia használatának elterjedésével és az alkalmazott mesterséges intelligencia eszközök sokszínűbbé válásával az AI-t alkalmazó intézményeknek a helyi AI irányítási folyamat egyik funkciójaként folyamatos teljesítményfelügyeletet kell kialakítaniuk. Fontos a nyomon követés és az irányítási stratégia annak biztosítására, hogy az AI-modellek idővel az elvárásoknak megfelelően teljesítsenek, mivel a nem észlelt teljesítménycsökkenés jelentős hatással lehet a betegbiztonságra és a betegellátásra. Egy olyan lehetséges jövőbeli állapotban, ahol az adaptív intelligencia lehetővé teszi a helyi modellfinomítást, a felügyeleti rendszereknek képesnek kell lenniük arra, hogy a folyamatosan tanuló mesterséges intelligencia-algoritmusok számára alapszintű és longitudinális visszacsatolási információkat is nyújtsanak.

Az ideális felügyeleti megoldás valós idejű adatokat gyűjt a modell teljesítményéről, összesíti és elemzi az eredményeket, összehasonlítva azokat a helyi, regionális vagy országos viszonyítási szinten elvárt teljesítménnyel, amennyiben ez megvalósítható. Ez a megközelítés azonban megköveteli, hogy az alapadatok és a jól meghatározott teljesítmény-összehasonlító referenciaértékek azonnal rendelkezésre álljanak, ami ma egyes felhasználási esetek és algoritmusok esetében megvalósítható, más esetekben azonban nem. A radiológusok által is jelentett leletek azonosítására hangolt, triázs típusú mesterséges intelligenciamodellek esetében az egyik gyakori megközelítés a radiológusi jelentések és a modell következtetési kimenete közötti egyezés vagy eltérés elemzése lenne. Ez a megközelítés nem biztos, hogy működik olyan kvantitatív kimenetek esetében, amelyeket ember nem tud könnyen reprodukálni, vagy olyan kockázati pontszámok esetében, amelyek érvényessége csak a longitudinális klinikai adatok elemzésével határozható meg. A nyomon követés további célpontjai közé tartoznak a bemeneti metaadatok (pl. a berendezés gyártója, a mágneses térerősség vagy a CT-detektorok száma), más releváns vizsgálati paraméterek és az egyes betegek releváns demográfiai adatai, mivel ezek közül bármelyik vagy több eltérése a gyártói előírásoktól a teljesítmény romlásához vezethet. A helyi AI-felügyeleti csoport feladata annak eseti alapon történő meghatározása, hogy egy adott algoritmusban milyen a megfelelő ellenőrzés. Minden esetben, de különösen kvantitatív modellek használata esetén a radiológusok képesek lehetnek meghatározni a mesterséges intelligencia kimenetének általános érvényességét azáltal, hogy megerősítik, hogy nincsenek olyan releváns képalkotási artefaktumok, amelyek zavarhatják a mesterséges intelligencia feldolgozását.

A mesterséges intelligencia klinikai gyakorlatban történő valós nyomon követésére vonatkozó stratégiáknak figyelembe kell venniük a használt mesterséges intelligencia modell típusát és a modell teljesítményének csökkenése esetén a betegbiztonságra jelentkező kockázatot. A képalkotó közösség számára fontos lesz olyan nyomon követési módszereket kidolgozni, amelyek a modell kimenetét a longitudinális elemzés megfelelő formáival (a jövőbeni képalkotó vagy EHR-ből származó adatokkal vagy ezek kombinációjával), az ugyanazon betegségfolyamat más klinikai biomarkerekkel való összehasonlítással, valamint az ugyanazon algoritmusnak számos betegnél és számos intézményben történő alkalmazásából származó teljesítményadatokkal való összehasonlítással kombinálják. Meg kell jegyezni, hogy a jelenlegi hatósági jóváhagyással rendelkező szinte valamennyi mesterséges intelligenciamodell esetében a modell következtetése a radiológusok értelmezéseinek kiegészítésére, nem pedig helyettesítésére szolgál, és ezért a diagnosztikai vagy triázs szoftverek betegspecifikus modellhibáit a felhasználó jellemzően a radiológiai jelentések véglegesítése és a betegellátás megkezdése előtt azonosítja. Amikor azonban megjelennek a felügyelet nélküli, autonóm módon működő mesterséges intelligencia-algoritmusok, a betegbiztonság garantálásához robusztus felügyeleti megoldásokra lesz szükség. A jövőbeni autonóm mesterséges intelligencia megvalósítása során a hibamódok és a kapcsolódó biztonsági háló folyamatainak alapos megértése kiemelkedő fontosságúvá válhat. Ezt a 8. szakaszban vizsgáljuk meg részletesebben. Bár arra számítunk, hogy a kereskedelmi forgalomban kapható mesterséges intelligencia-megoldások legtöbb fejlesztője aktívan részt vesz majd a termékeik hatékonyságának nyomon követésére szolgáló mechanizmusok kidolgozásában, jelenleg nincs tudomásunk arról, hogy a gyártóknak konkrét szabályozási követelményeket kellene támasztaniuk a mesterséges intelligencia teljesítményének longitudinális nyomon követésével kapcsolatban, amelyet a szabályozó hatóságok gyakran forgalomba hozatal utáni felügyeletnek neveznek. Ennek eredményeképpen a születőben lévő felügyeleti megoldások nem szabványosítottak. A modelltől és a betegbiztonságot fenyegető kockázattól függően különböző nyomonkövetési stratégiákat lehet alkalmazni, a valós idejű folyamatos nyomon követéstől kezdve az időszakos nyomon követésig. Az intézményeknek világosan meghatározott eszkalációs és megoldási stratégiát kell kidolgozniuk arra az esetre, ha a monitorozás modellhibát vagy teljesítményeltolódást észlel, amely meghatározza az értesítést és az intézkedési tervet, valamint a működési módot, amíg a modell teljesítményét értékelik és a modellhiba okát meghatározzák. A felügyeleti stratégia minden esetben elsősorban a jól meghatározott teljesítményparaméterek vagy egy könnyen hozzáférhető összehasonlító paraméter (például referenciaérték vagy alapigazság) megvalósíthatóságán alapul.

A modell teljesítményének rendszeres ellenőrzése

A mesterséges intelligenciamodell teljesítményének meghatározott időközönként, de legalább évente frissített helyi adatsorok felhasználásával történő újraértékelése megfelelő nyomon követési mechanizmus lehet olyan modellek esetében, ahol a modell teljesítményére vonatkozó valós idejű adatok gyűjtése korlátozott (számszerűsítés, munkafolyamatok javítása stb.), vagy olyan esetekben, amikor a betegbiztonságra nincs közvetlen hatással. Egy ilyen rendszer megköveteli, hogy egy új, naprakész értékelési adathalmazt hozzanak létre megfelelő számú klinikai eset és a kezdeti validálási halmazhoz hasonló paraméterek felhasználásával, hogy a modell teljesítményét az aktuális körülmények között újraértékeljék. Bár az ilyen típusú teljesítmény-ellenőrzési rendszer számos klinikai használatban lévő mesterséges intelligencia modell esetében hasznos lehet, a korlátok közé tartozik a modell folyamatos használata és a diszkrét ellenőrzési tevékenység bekövetkezése közötti időeltolódás, ami késlelteti az intézmények azon képességét, hogy javító intézkedéseket tegyenek, ha romlás következik be. Egy másik konkrét forgatókönyv, amely szükségessé teheti a modell teljesítményének újraértékelését, az lenne, ha a gyártó új modellváltozatot bocsátana ki. A felhasználói helyek nem feltételezhetik egyszerűen, hogy a gyártó által a modell legújabb verziójának bevezetésével bevezetett előnyök automatikusan általánossá válnak a helyi gyakorlatban.

A modellteljesítményt befolyásoló adateltolódás okainak nyomon követése

Mivel a berendezésekben, a protokollokban és a populáció demográfiájában bekövetkező természetes változások ismert okai a bemeneti adatok (forráskép) eltolódásának és a mesterséges intelligenciamodell teljesítményének esetleges csökkenésének, az intézmények dönthetnek úgy, hogy a modell elfogadásakor meghatározzák a bemeneti adatok alapjellemzőit, majd az egyes mesterséges intelligenciamodellekre jellemző alapállapothoz képest figyelemmel kísérik az adatok eltolódását. A bemeneti paraméterekben bekövetkező releváns változások azonosítása elindíthatja a fent leírt, időszakos nyomon követésre vonatkozó újraértékelési folyamatot. Az adateltolódás egyes összetevőinek nyomon követésével az intézmények a változások időzítésétől és súlyosságától függően újraértékelhetik a modell teljesítményét, és megfelelő lépéseket kezdeményezhetnek a betegellátás védelme érdekében.

A modell teljesítményének folyamatos nyomon követése

A mesterséges intelligenciamodell teljesítményének folyamatos nyomon követésére irányuló stratégiák számos olyan kockázatot lefednek, amelyeket a mesterséges intelligenciamodell bevezetése előtt kell értékelni (lásd a fenti 6. szakaszt). Bár a statisztikai paraméterek, például az érzékenység, a specificitás és a pozitív prediktív érték valós idejű meghatározása nem lehetséges a folyamatos nyomon követés során, az algoritmus teljesítménye az értelmező radiológus végleges jelentéséhez képest - amennyiben lehetséges - a modell pontosságának helyettesítőjeként használható. A fentieknek megfelelően a vizsgálatra vonatkozó metaadatok gyűjtésének részét kell képeznie ennek a nyomon követésnek, és tartalmaznia kell a berendezés gyártóját, az alkalmazott protokollt, a sugárdózist és a beteg demográfiai adatait. Ha rendelkezésre áll, a radiológus egyidejű értelmezése a "ground truth" helyettesítőjének tekinthető, de ennek az opportunista címkézésnek az erőssége eltérhet a kezdeti validációs vizsgálatok során megadott címkézéstől. Ideális esetben ez az adatgyűjtés a háttérben történhetne, a megfelelő természetes nyelvi feldolgozási módszerekkel automatikusan kinyert információk összehasonlításával a radiológusok jelentéseivel, mint a mesterséges intelligencia pontosságának mérőszámával, valamint a DICOM fejlécben szereplő adatokkal, hogy lehetőség szerint figyelemmel lehessen kísérni a vizsgálati paramétereknek a mesterséges intelligencia gyártójának a bemeneti adatokra vonatkozó specifikációinak való megfelelését. A DICOM fejlécében korlátozott mennyiségű demográfiai adat is található, és ezeket is be kell építeni az adatgyűjtésbe. A megbízhatóbb felügyeleti és torzításfelismerési megoldásokhoz szükség lehet a beteg demográfiai adatainak bővítésére. A folyamatos AI-monitorozás számos előnnyel jár az epizodikus újraértékelésekkel szemben. Az AI-modell teljesítményére vonatkozó releváns információkat egy erre a célra létrehozott AI-adatnyilvántartásban kell rögzíteni, amely lehetővé teszi a több helyszínen és földrajzi területen történő jelentések készítését. Az ilyen összehasonlító adatok hasznosak lehetnek az egyes helyszínek és a mesterséges intelligenciamodellek szállítói számára is. Helyi szinten a nyilvántartási jelentések lehetővé tennék az intézmények számára, hogy saját helyi környezetükben azonosítsák a teljesítményromlást, és lehetővé tennék a potenciális adateltolódás forrásainak szisztematikus értékelését közel valós időben. Például egy olyan intézmény, amelynek klinikai munkafolyamatában több CT is működik, azonosíthatná a teljesítmény romlását a saját korábbi teljesítményéhez képest egy intrakraniális vérzés kimutatására tervezett mesterséges intelligenciamodellben. Elméletileg az összesített intézményi nyilvántartási adatok elemzése azt mutathatja, hogy a gyenge teljesítmény egyetlen gépre korlátozódik. További elemzés azt is megmutathatja, hogy a teljesítményromlás az adott gép szoftverfrissítése vagy a vizsgálati protokoll megváltoztatása után következett be. A fel nem dolgozott esetek szisztematikus elemzése egy másik fontos ellenőrzési célpontot jelent. Az ilyen esetek az adatgyűjtés vagy az adatátvitel szisztematikus vagy anekdotikus hibájára utalhatnak, ami akadályozza a mesterséges intelligenciára való következtetést, és megakadályozza, hogy a későbbi klinikai lépések hasznot húzzanak belőle. A nem teljesítés nyomon követése a klinikai mesterséges intelligencia helyi minőségbiztosítási rendszerének fontos építőköve, amely egyre fontosabb lesz, ahogy a jövőben a klinikai vállalkozás egyre nagyobb mértékben függ a mesterséges intelligenciától.

Az ugyanazon mesterséges intelligenciamodelleket használó több intézménytől származó adatok összesítése információt nyújthat a fejlesztők számára a teljesítménybeli hiányosságok azonosításához, amelyeket az algoritmus jövőbeli verzióiban orvosolni lehet, valamint a forgalomba hozatal utáni felügyeleti szabályozási követelményeknek való megfeleléshez. Bár a klinikai használatban lévő mesterséges intelligenciamodellek egyike sem alkalmazza a folyamatos tanulást a modellfejlesztés vagy a helyi hangolás eszközeként, a folyamatos felügyeleti megoldások egyik feltételezett előnye, hogy a jövőbeni adaptív mesterséges intelligenciamodelleket további képzési adatokkal lehet ellátni a folyamatos tanuláshoz. A folyamatos megfigyelés megközelítésének azonban jelentős korlátai vannak. Ma az ilyen megoldások nem feltétlenül alkalmazhatók sok (vagy egyáltalán nem alkalmazhatóak) mesterséges intelligencia modell esetében, beleértve a kvantitatív feladatokat végrehajtó modelleket és más olyan mesterséges intelligencia modelleket, amelyek teljesítménye nem mérhető valós időben. Továbbá a folyamatos megfigyelés megköveteli egy adott intézményen belül a termelési rendszerek integrációját, beleértve olyan információkat is, amelyek helyi segítség és a szükséges infrastruktúra nélkül nem feltétlenül hozzáférhetőek egy gyártó számára. Az erre vonatkozó szabványok, a konkrét szabályozási útmutatás és a mesterséges intelligencia-nyilvántartásokhoz szükséges informatikai infrastruktúra nem létezik széles körben, és a legtöbb intézmény számára valószínűleg költség- és erőforrásigényes lesz a belső folyamatos nyomon követési megoldások kifejlesztése. A mesterséges intelligencia-regiszterek kísérleti projektjei folyamatban vannak; a mesterséges intelligencia teljesítményjelzéseinek idővel történő összesítése és elemzése fontosságának jobb megértése valószínűleg növelni fogja a végfelhasználók érdeklődését a regiszterekben való részvétel iránt, és költséghatékony lehetőséget jelenthet az ügy támogatására. A szabályozási követelmények vagy a folyamatos tanuláson alapuló mesterséges intelligenciamodellek elérhetőségének hiányában azonban a kereslet korlátozott lehet. Jelenleg kevés olyan mesterséges intelligenciamodell létezik korlátozott piacokon, amelyek rendelkeznek az önállóan működő mesterséges intelligenciára vonatkozó szabályozási jóváhagyással, és a modellteljesítmény értékelésének paramétereit és gyakoriságát még meg kell határozni. Ezek a paraméterek az értékelendő betegségfolyamat, a modell hibája esetén a betegre jelentkező kockázat és a betegség előfordulási gyakorisága függvényében változnak a célpopulációban. Ezért elképzelhető, hogy a teljesítmény nyomon követése magában foglalhatná az előre meghatározott számú esetek időszakos véletlenszerű mintavételezését, a teljesítmény időbeli szúrópróbaszerű nyomon követése érdekében a valósággal való összehasonlítással.

Jövőbeni helyi hangolás és folyamatos tanulás AI algoritmusok

A mesterséges intelligenciamodellek helyi hangolása és a folyamatos tanulású mesterséges intelligencia-algoritmusok telepítés előtti helyi hangolása elméletileg javíthatja a mesterséges intelligencia-termékek helyi teljesítményét. Eddig azonban minden olyan mesterséges intelligencia-eszköz, amely megkapta a hatósági jóváhagyást, statikus, és nem lehet helyileg hangolni, illetve adaptív tanulási technikákkal módosítani. Az Egyesült Államok Élelmiszer- és Gyógyszerügyi Hivatala (FDA) a közelmúltban közzétette az "előre meghatározott módosítási ellenőrzési terv" tervezetét, amely lehetővé tenné a kereskedelmi algoritmusok jövőbeni módosítását mind a helyi hangolás, mind a folyamatos tanulás tekintetében. Bármely változtatás-ellenőrzési tervnek tartalmaznia kell a robusztus, valós idejű mesterséges intelligenciamodell teljesítményét és a betegkockázatot csökkentő intézkedéseket. Jelenleg ezt az iránymutatást még nem hajtották végre, de inkább a jóváhagyási eljárás alatt álló modellekre vonatkozna, mint a már jóváhagyott modellekre.

Egyéb megfontolások: Az AI irányítása, a technológiai életciklus és a helyi felhasználói környezet kezelése.

Tekintettel a mesterséges intelligencia életciklusának klinikai környezetben történő kezelésének összetettségére, a klinikai mesterséges intelligencia használatában részt vevő szolgáltató szervezetek jól járnak, ha formalizálják a helyi mesterséges intelligencia irányítási felügyeletét és a kapcsolódó folyamatokat. Erre azért van szükség, hogy kezelni lehessen a mesterséges intelligencia termék életciklusának valamennyi szakaszában jelentkező számos kihívást, amelyek közé tartozik a jól működő mesterséges intelligencia beszerzése, teljesítményének idővel történő nyomon követése, a helyi környezet (pl. szkenner protokollok, mesterséges intelligencia összehangolása, eszközkonfiguráció, munkafolyamat-integráció, beleértve az alapigazság címkék opportunista rögzítését stb.) idővel szükség szerinti kiigazítása, valamint a jelenleg alkalmazott termékek jövőbeli frissítésekkel vagy alternatív termékekkel történő cseréjének szabályos folyamata. Gyakran elfelejtik, de nem kevésbé fontosak a klinikai végfelhasználók, a radiológusok és a műszaki személyzet, köztük az informatikusok körében egyre gyakoribbá váló fluktuáció hatásai. Ahogy új felhasználók érkeznek a helyi rendelőbe, őket megfelelően be kell illeszteni, el kell igazítani és ki kell képezni a rendelkezésre álló mesterséges intelligencia eszközökben és a kapcsolódó munkafolyamatokban, hogy hatékony résztvevői lehessenek ennek a technológiával támogatott ellátási paradigmának. Annak biztosítása, hogy minden helyi érdekelt fél naprakész és kompetens legyen az AI-technológia használatában, a szállítók és a helyi intézményi irányítás és felügyelet vezetőinek közös felelőssége.

Vidd haza:

A mesterséges intelligenciamodellek teljesítményének klinikai gyakorlatban történő nyomon követésére van szükség annak biztosítása érdekében, hogy a teljesítményromlást időben felismerjék, és így megfelelő intézkedéseket lehessen hozni a betegbiztonság érdekében. Legalább évente újra kell értékelni a modellteljesítmény értékelésének szükségességét, és nyomon kell követni azokat a paramétereket, amelyekről ismert, hogy összefüggésben állnak a bemeneti adatok eltérését kiváltó tényezőkkel. A gyakoribb újraértékelés szükségességét a modell meghibásodása esetén a betegkockázat és az adott mesterséges intelligenciamodell kimenetének klinikai döntési relevanciája alapján is mérlegelni kell. Bár nem alkalmazható minden mesterséges intelligenciamodellre és klinikai gyakorlatra, a modell teljesítményét, a vizsgálati paramétereket és a betegek demográfiai adatait adatnyilvántartásokban rögzítő folyamatos mesterséges intelligencia-monitorozás jelentős előnyöket kínál a mesterséges intelligenciamodellek időszakos újraértékelésével szemben, beleértve a teljesítménycsökkenés helyi okainak valós idejű azonosítását, és a fejlesztőknek a modellfejlesztéshez szükséges összesített adatok biztosítását. Az önállóan működő mesterséges intelligencia-algoritmusok telepítése előtt szükség lesz a teljesítmény megbízható, folyamatos nyomon követésére, és ez a folyamatosan tanuló mesterséges intelligencia-modellek elengedhetetlen feltétele is.

Kulcsfontosságú - A mesterséges intelligencia eszközök hosszú távú stabilitása és biztonsága -

- A természetben előforduló adateltolódás miatt a mesterséges intelligenciamodellek teljesítménye idővel romlik, és a végfelhasználóknak számolniuk kell vele.

- A felügyeleti stratégiáknak legalább évente újra kell értékelniük a klinikai gyakorlatban használt összes mesterséges intelligenciamodell teljesítményét, hogy megfelelő intézkedéseket lehessen hozni a betegbiztonság érdekében.

- A bemeneti adatok eltérésével kapcsolatban ismert paraméterek változásainak nyomon követése gyakoribb újraértékeléseket válthat ki.

- A folyamatos mesterséges intelligencia-megfigyelési megoldások, amelyek a modellek teljesítményét, a vizsgálati paramétereket és a betegek demográfiai adatait adatnyilvántartásokban rögzítik, amelyek a végfelhasználók és a fejlesztők számára jelentéseket biztosítanak, jelentős előnyöket kínálnak a mesterséges intelligencia-modellek időszakos újraértékelésével szemben.

- Az önállóan működő mesterséges intelligencia-algoritmusok telepítése előtt szükség lesz a teljesítmény megbízható, folyamatos teljesítményfigyelésére, és a folyamatosan tanuló mesterséges intelligencia-modellek esetében is szükséges.

8. szakasz: Hogyan tudjuk felmérni, hogy a (teljesen vagy részben) autonóm mesterséges intelligencia valószínű/megfelelő/biztonságos-e egy adott klinikai környezetben?

A radiológiában a mesterséges intelligencia alkalmazásának két különböző forgatókönyve létezik: a kiterjesztő mesterséges intelligencia és az autonóm mesterséges intelligencia, amelyek mindegyike egyedi szempontokat vet fel, amelyek a betegellátás összefüggésében mind biztonsági, mind etikai szempontból szigorú vizsgálatot igényelnek.

Augmentatív (képző) mesterséges intelligencia

Ebben a forgatókönyvben a radiológusok együttműködnek az AI rendszerekkel a diagnosztikai pontosság növelése és a hatékonyság növelése érdekében. Ez az együttműködés lehetőséget nyújt a radiológusok által nyújtott érték növelésére, de nem mentes a kihívásoktól. Amint azt a 6. szakaszban (Az ember és az AI közötti kölcsönhatás) tárgyaltuk, az egyik alapvető kérdés az ember és a számítógép közötti torzítások lehetséges megjelenése a radiológiai értelmezésben. Ezeket az előítéleteket tisztázni és kezelni kell annak érdekében, hogy a mesterséges intelligencia kimenete ne befolyásolja negatívan a radiológus ítéletét. Az ember-számítógép rendszerben kétféle általános torzítás vezethető be: a túlzott és az alulbízás. A túlzott megbízhatóság, más néven automatizálási torzítás növeli a hamis pozitív (FP) és hamis negatív (FN) eredmények kockázatát: ha a mesterséges intelligenciának az esetek többségében igaza van, a radiológus abbahagyhatja a kimenetek ellenőrzését, vagy jobban megbízik a mesterséges intelligenciában, mint saját ítélőképességében. Ebben a forgatókönyvben a radiológus elfogadja az AI hibás eredményeit. Az alulbízás ugyanezt a hatást váltja ki, de az ellenkező okból. Ha a radiológus nem bízik a mesterséges intelligencia eredményeiben, figyelmen kívül hagyhatja a pontos mesterséges intelligencia kimenetet, ami szintén növeli az FP és FN eredményeket. Végső soron a radiológus és az AI rendszer kombinációjának kimenetét kell optimalizálni. Ezeket a kihívásokat tovább súlyosbíthatja a negatív munkahelyi hozzáállás (85) és a személyes felelősségérzetet csökkentő tényezők (86), beleértve a radiológus kiégését és a nagy munkaterhelést, amelyek jelenleg mindketten mindenütt jelen vannak a radiológiai gyakorlatban.

A megbízhatósággal kapcsolatos előítéletek és kihívások mérséklésének szilárd megközelítése magában foglalja a radiológusok folyamatos oktatását a mesterséges intelligencia képességeiről és korlátairól. A mesterséges intelligenciával kapcsolatos döntéshozatalról, annak eredményeiről és a megbízhatósági szintekről szóló átfogó tájékoztatás fokozhatja az átláthatóságot és segítheti a radiológusokat abban, hogy megalapozott döntéseket hozzanak. Emellett az olyan forgatókönyvek kategorizálása, amelyekben a mesterséges intelligenciával történő segítségnyújtás hibázhat, és ezen információk integrálása egy erőteljes képzési programba képessé teheti a radiológusokat a hibák felismerésére és kijavítására. A mesterséges intelligencia rendszer pontossága is befolyásolja a rad-AI elfogultságot - a pontosabb AI eredmények csökkentik az elfogultságot (87). Ezért a legpontosabb AI-modell azonosításának klinikai jelentősége van. Végül a rad-AI pontosságának mérése az irányított visszajelzésekkel együtt tovább finomíthatja a rendszer teljesítményét.

Az augmentatív mesterséges intelligenciával kapcsolatos etikai megfontolások sokrétűek. Azokban az esetekben, amikor a radiológus szakorvosok létszáma korlátozott, a mesterséges intelligencia bevezetése jelentősen befolyásolhatja a betegek eredményeit. A mesterséges intelligenciára való támaszkodás azonban olyan dilemmához vezethet, amelyben a mesterséges intelligencia jelenléte befolyásolhatja a szakorvosok képzésére és megtartására szánt erőforrások elosztását. Gondos mérlegelésre van szükség az erőforrás-korlátozott környezetben a mesterséges intelligenciával történő kiegészítés etikai következményeinek mérlegeléséhez.

Autonóm mesterséges intelligencia

Az augmentatív mesterséges intelligenciával ellentétben az autonóm mesterséges intelligencia közvetlen emberi felügyelet nélkül működik, és önálló diagnosztikai döntéseket hoz. Ez a forgatókönyv fokozott biztonsági és etikai megfontolásokat vet fel. Az autonóm mesterséges intelligenciát szigorú teljesítménynormáknak, valamint átfogó és folyamatos tesztelésnek kell alávetni, hogy megbízhatóságát és pontosságát biztosítani lehessen. Alapvető fontosságú a rendszer hibamódjainak kritikus értékelése, figyelembe véve, hogy a hatósági jóváhagyásból származó statisztikák vagy a gyártó által megadott pontossági arányok nem feltétlenül tükrözik megfelelően a különböző környezetek valós teljesítményét.